AI assistentie wordt steeds meer gemeengoed bij software development. Met commerciële tools deel je echter mogelijk gevoelige informatie met een externe bedrijf. Dit is meestal niet wenselijk. Met de laatste open-source modellen kun je lokaal je eigen AI assistent draaien, waardoor je niet langer afhankelijk bent van externe oplossingen. In dit artikel laten we zien hoe je met Ollama zelf modellen lokaal kunt draaien.

Ollama is een open-source platform waarmee je verschillende modellen lokaal kunt draaien. Er zijn installers beschikbaar voor MacOS, Linux en Windows. Nadat je deze hebt geïnstalleerd kun je in de terminal verschillende modellen proberen te draaien.

Voor echt grote modellen heb je een flinke GPU nodig, maar met de nieuwe R1 modellen van Deepseek kun je zelfs op een MacBook al geavanceerde modellen draaien met goede prestaties.

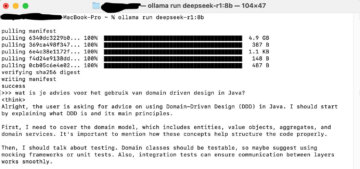

In dit geval kozen we voor het 8b model van Deepseek R1, je kunt deze andere terminal commando’s op deze pagina terugvinden.

ollama run deepseek-r1:8b

Je kunt daarna direct in de terminal een interactie aangaan met het model.

Zoals je ziet geeft R1 ook inzicht in het gedachteproces achter het antwoord. Dit helpt enorm bij het sturen en corrigeren van het model, en zorgt ervoor dat je makkelijker bij je gewenste output komt.

De terminal interface is beperkt, ook qua opmaak. Er zijn allerlei tools en frontends die je kunt gebruiken. Een simpele gratis tool is Chatbox, deze kun je hier downloaden.

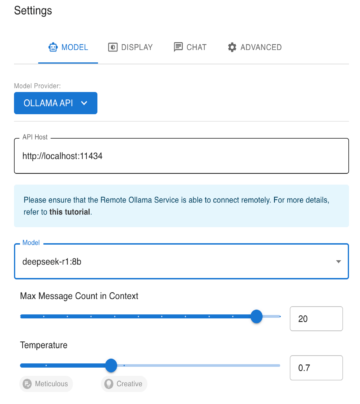

Vervolgens kun je in de settings zorgen dat de app praat met je lokale model:

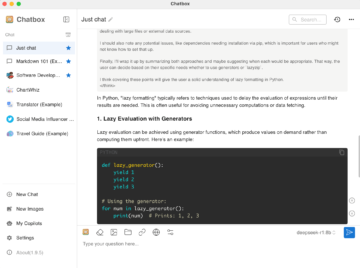

Nu kun je op een gebruiksvriendelijke manier je eigen model gebruiken:

Je ziet nu het eerste blok in grijs, waar het model het gedachteproces weergeeft, en dan de rest van het antwoord. Ook code-blokken en andere formattering wordt nu correct weergegeven.

De mogelijkheden zijn eindeloos: gebruik hem als code-assistent, therapeut of taal-leraar.

Dankzij deze steeds slimmere open-source modellen zijn er steeds meer mogelijkheden voor de software ontwikkelaar. Door je eigen model te draaien weet je zeker dat er geen gevoelige data naar een externe partij lekt. Op deze manier kun je ook AI tools gebruiken wanneer je voor klanten werkt waarbij geen data met externe partijen gedeeld mag worden.

Heb jij interessante suggesties of aanvullingen over het gebruik van AI tools als developer? Wij horen het graag: laat het ons weten via inbox@eonics.nl, dan nemen we jouw input mee voor een toekomstig artikel.

ps. lees ook ons artikel over AI versus Google: de toekomst van zoeken op het web?